开源大模型超越GPT-3.5!爆火MoE实测结果出炉,网友:OpenAI越来越没护城河了

开源大模型超越GPT-3.5!爆火MoE实测结果出炉,网友:OpenAI越来越没护城河了一条神秘磁力链接引爆整个AI圈,现在,正式测评结果终于来了:首个开源MoE大模型Mixtral 8x7B,已经达到甚至超越了Llama 2 70B和GPT-3.5的水平。

一条神秘磁力链接引爆整个AI圈,现在,正式测评结果终于来了:首个开源MoE大模型Mixtral 8x7B,已经达到甚至超越了Llama 2 70B和GPT-3.5的水平。

前几日,一条MoE的磁力链接引爆AI圈。刚刚出炉的基准测试中,8*7B的小模型直接碾压了Llama 2 70B!网友直呼这是初创公司版的超级英雄故事,要赶超GPT-4只是时间问题了。有趣的是,创始人姓氏的首字母恰好组成了「L.L.M.」。

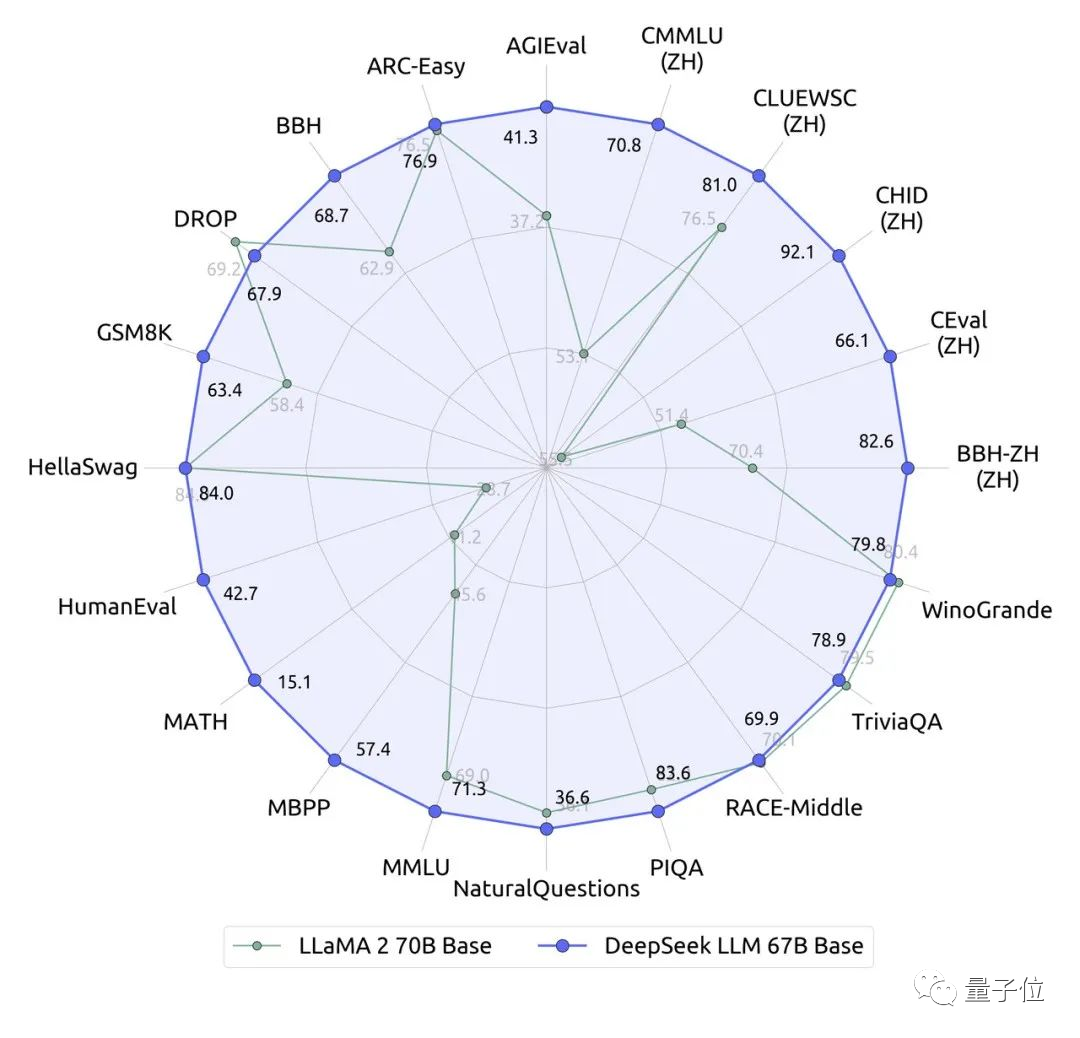

国产大模型刚刚出了一位全新选手:参数670亿的DeepSeek。它在近20个中英文的公开评测榜单上直接超越了同量级、700亿的Llama 2。

通义千问开源全家桶正式上线!业界最强72B模型直接超越开源标杆Llama 2-70B,还有1.8B模型、音频大模型全部开源,阿里云这次真的把家底都掏出来了。

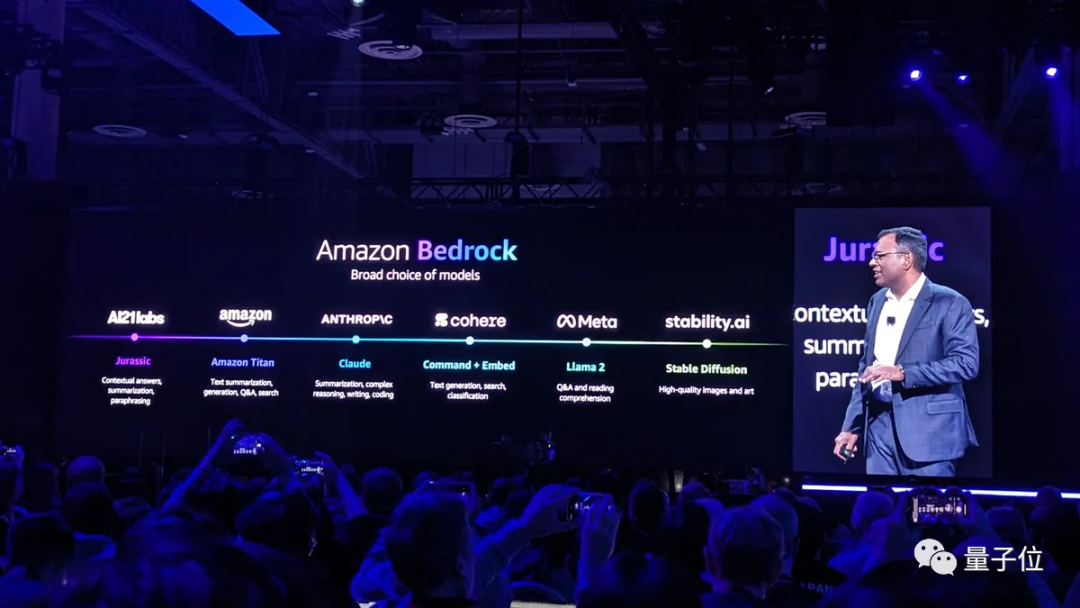

好消息,搞生成式AI应用的门槛,被狠狠地打下去了!就在刚刚,亚马逊云科技在年度盛会re:Invent中正式宣布:

大语言模型「拍马屁」的问题到底要怎么解决?最近,LeCun转发了Meta发布的一篇论文,研究人员提出了新的方法,有效提升了LLM回答问题的事实性和客观性。我们一起来看一下吧。

我们都知道,大语言模型(LLM)能够以一种无需模型微调的方式从少量示例中学习,这种方式被称为「上下文学习」(In-context Learning)。这种上下文学习现象目前只能在大模型上观察到。比如 GPT-4、Llama 等大模型在非常多的领域中都表现出了杰出的性能,但还是有很多场景受限于资源或者实时性要求较高,无法使用大模型。

前不久,原阿里首席AI科学家贾扬清的一条朋友圈截图四处流传。贾扬清说,他的一个朋友告诉他,某国产大模型不过是LLaMA架构,只是更换了几个变量名而已。 很快有好事者发现,在大模型、数据集开源社区Hugging Face上,就有一位开发者发出了类似质疑:“该模型使用了Meta LLaMA 的架构,只修改个tensor(张量)”。

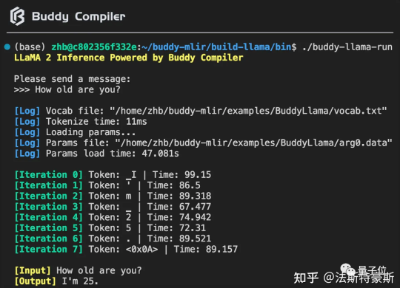

Buddy Compiler 端到端 LLaMA2-7B 推理示例已经合并到 buddy-mlir仓库[1]主线。我们在 Buddy Compiler 的前端部分实现了面向 TorchDynamo 的第三方编译器,从而结合了 MLIR 和 PyTorch 的编译生态。

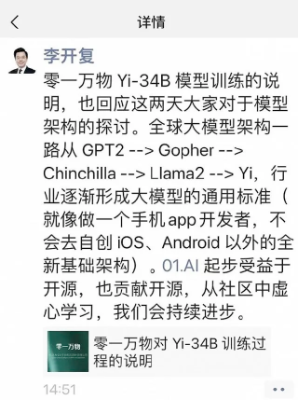

针对近日零一万物被质疑完全使用 LLaMA 架构,只对两个张量(Tensor)名称做修改,李开复在朋友圈进行了回应。